Πώς το Facebook εθίστηκε στη διάδοση της παραπληροφόρησης

ΕΛΛΑΔΑΚΟΙΝΩΝΙΑΚΟΣΜΟΣ 31 Μαρτίου 2022 fonisalaminas

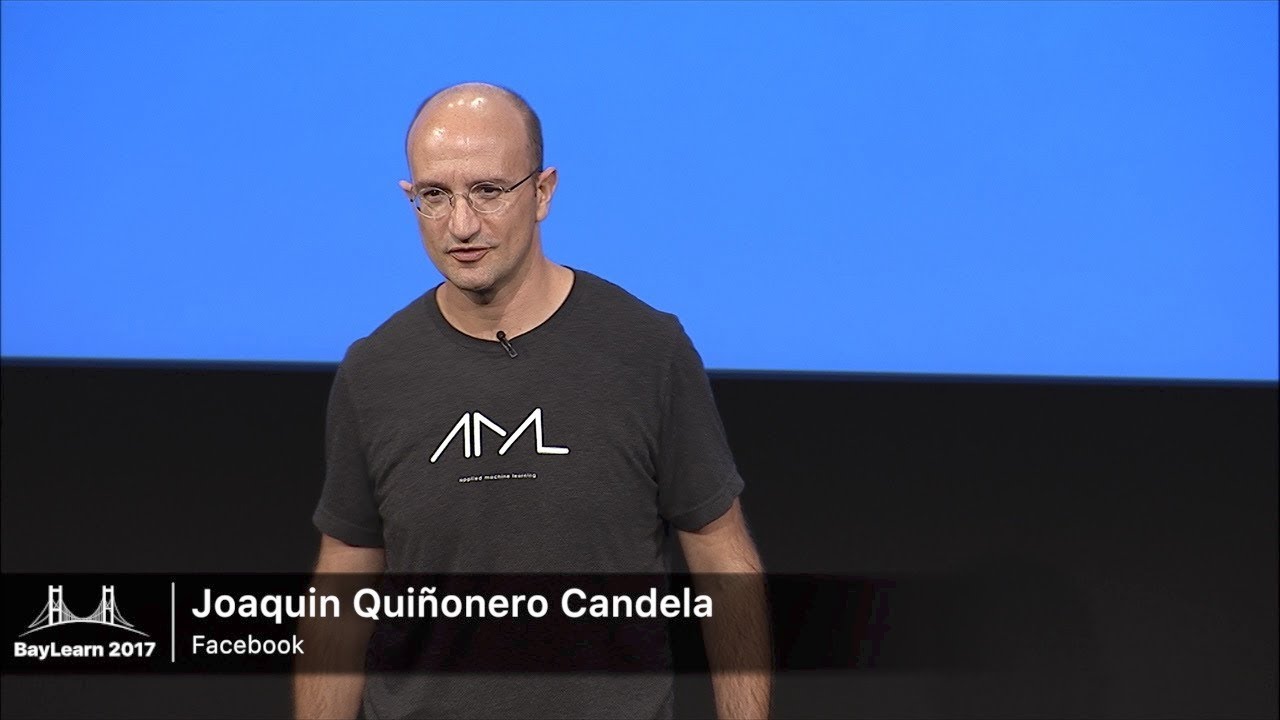

Στις 23 Μαρτίου 2018, λίγες ημέρες μετά την αποκάλυψη του σκανδάλου της Cambridge Analytica, ο Χοακίν Κινιονέρο Καντέλα, διευθυντής Τεχνητής Νοημοσύνης (AI) στο Facebook, ετοιμαζόταν να μιλήσει σε ένα συνέδριο της εταιρείας για «τη διασταύρωση της τεχνητής νοημοσύνης, της ηθικής και της ιδιωτικής ζωής». Όταν ανέβηκε στη σκηνή ξεκίνησε λέγοντας στο ακροατήριό του: «Μόλις πέρασα τις πιο δύσκολες πέντε ημέρες στη θητεία μου στο Facebook. Αν θέλετε να κάνετε κριτική, θα τη δεχτώ».

Το σκάνδαλο της Cambridge Analytica είναι το μεγαλύτερο στην ιστορία του Facebook. Σύμφωνα με έρευνα που πραγματοποίησαν οι New York Times και η Observer, η εταιρεία ανάλυσης δεδομένων Cambridge Analytica συγκέντρωσε χωρίς τη συγκατάθεσή τους, προσωπικά δεδομένα 87 εκατομμυρίων χρηστών του Facebook, σε μια προσπάθεια να επηρεάσει την ψήφο τους υπέρ του Ντόναλντ Τραμπ, κατά την προεκλογική εκστρατεία του 2016.

Το σκάνδαλο πυροδότησε τη μεγαλύτερη κρίση που έχει αντιμετωπίσει ποτέ το Facebook. Ενίσχυσε τους φόβους ότι οι αλγόριθμοι που καθορίζουν αυτά που βλέπουν οι άνθρωποι στην πλατφόρμα, ενισχύουν τις ψευδείς ειδήσεις και τη ρητορική μίσους και ότι οι Ρώσοι χάκερ τους είχαν χρησιμοποιήσει για να προσπαθήσουν να επηρεάσουν τις εκλογές υπέρ του Τραμπ. Εκατομμύρια άνθρωποι άρχισαν να διαγράφουν την εφαρμογή, εργαζόμενοι της εταιρείας αποχώρησαν σε ένδειξη διαμαρτυρίας, η εταιρεία έχασε περισσότερα από 100 δισεκατομμύρια δολάρια σε κεφαλαιοποίηση αγοράς τις επόμενες ημέρες και πολιτικοί στις ΗΠΑ και τη Μεγάλη Βρετανία ζήτησαν απαντήσεις από τον Μαρκ Ζούκερμπεργκ.

Στους μήνες που ακολούθησαν, ο Ζούκερμπεργκ άρχισε να ζητάει συγγνώμη. Ζήτησε συγγνώμη επειδή δεν είχε συνολική εικόνα για τις ευθύνες του Facebook, καθώς και για τα λάθη του ως διευθύνων σύμβουλος. Η Σέριλ Σάντμπεργκ, η διευθύνουσα σύμβουλος της εταιρείας, ξεκίνησε μια διετή έρευνα σχετικά με τα πολιτικά δικαιώματα, ώστε να βρει τρόπους με τους οποίους η εταιρεία θα μπορούσε να αποτρέψει τη χρήση της πλατφόρμας της για την υπονόμευση της δημοκρατίας.

Ο Μάικ Σρέπφερ, επικεφαλής τεχνολογίας του Facebook, ζήτησε από τον Κινιονέρο να στήσει μια ομάδα με σκοπό να εξετάσει τον κοινωνικό αντίκτυπο των αλγορίθμων της εταιρείας. Η ομάδα ονομάστηκε Society and AI Lab (SAIL) και πέρυσι συγχωνεύτηκε με μια άλλη ομάδα η οποία ασχολείται με θέματα προστασίας των προσωπικών δεδομένων. Από τη συγχώνευση αυτή, προέκυψε η Responsible AI.

Ο Κινιονέρο ήταν μια πολύ καλή επιλογή για τη θέση αυτή. Στα έξι χρόνια που εργάστηκε στο Facebook, δημιούργησε μερικούς από τους πρώτους αλγορίθμους για τη στόχευση των χρηστών με περιεχόμενο προσαρμοσμένο στα ενδιαφέροντά τους, και στη συνέχεια έδωσε αυτούς τους αλγορίθμους σε όλη την εταιρεία. Τώρα, έπρεπε να τους κάνει λιγότερο επιβλαβείς.

Το Facebook έχει επανειλημμένα επισημάνει τις προσπάθειες του Κινιονέρο και άλλων προσπαθώντας να αποκαταστήσει τη φήμη του. Επιστρατεύει τακτικά διάφορους ηγέτες για να μιλήσουν στα μέσα μαζικής ενημέρωσης σχετικά με τις συνεχιζόμενες μεταρρυθμίσεις της πλατφόρμας. Τον Μάιο του 2019, ο Σρέπφερ παραχώρησε μια σειρά συνεντεύξεων στους New York Times εκ μέρους της εταιρείας. Παρουσιάστηκε ως ένα ευαίσθητο, καλοπροαίρετο στέλεχος που προσπαθούσε να ξεπεράσει τις τεχνικές προκλήσεις του φιλτραρίσματος της παραπληροφόρησης και της ρητορικής μίσους από μια ροή περιεχομένου που ανέρχεται σε δισεκατομμύρια αναρτήσεις την ημέρα. «Αυτές οι προκλήσεις είναι τόσο δύσκολες που κάνουν τον Σρέπφερ να δακρύζει», έγραψαν οι ΝΥΤ.

Την άνοιξη του 2020, η Αμερικανίδα δημοσιογράφος στο MIT Technology Review και επιστήμονας δεδομένων, Κάρεν Χάο, έλαβε ένα email από τον Άρι Έντιν, τον διευθυντή επικοινωνίας στο τμήμα Τεχνητής Νοημοσύνης του Facebook, ο οποίος τη ρώτησε αν ήθελε να μάθει περισσότερα για το έργο της εταιρείας στον τομέα της τεχνητής νοημοσύνης.

Η δημοσιογράφος μίλησε με αρκετούς από τους ηγέτες της AI και αποφάσισε να επικεντρωθεί στον Κινιονέρο. Ο Έντιν δέχτηκε ευχαρίστως. Ως επικεφαλής της ομάδας Responsible AI αλλά και ως ο άνθρωπος που είχε μετατρέψει το Facebook σε μια εταιρεία με γνώμονα την τεχνητή νοημοσύνη, ο Κινιονέρο ήταν μια καλή επιλογή για να χρησιμοποιηθεί ως πρότυπο.

Μετά το σκάνδαλο της Cambridge Analytica, οι ανησυχίες σχετικά με τη διάδοση των ψευδών ειδήσεων και της ρητορικής μίσους στο Facebook είχαν αυξηθεί. Στα τέλη του 2018 η εταιρεία παραδέχθηκε ότι δεν είχε κάνει αρκετά για να αποτρέψει την υποκίνηση βίας και ρητορικής μίσους εναντίον των Ροχίνγκια, της μουσουλμανικής μειονότητας στη Μιανμάρ.

Το 2020 το Facebook άρχισε να λαμβάνει μέτρα κατά των αρνητών του Ολοκαυτώματος, των αντιεμβολιαστών και του κινήματος συνωμοσίας QAnon. Όλα αυτά τα επικίνδυνα ψεύδη εξαπλώθηκαν χάρη στις δυνατότητες της τεχνητής νοημοσύνης που είχε βοηθήσει να δημιουργήσει ο Κινιονέρο. Οι αλγόριθμοι που στηρίζουν την επιχειρηματική δραστηριότητα του Facebook δεν δημιουργήθηκαν για να φιλτράρουν ό,τι είναι ψευδές ή εμπρηστικό- σχεδιάστηκαν για να κάνουν τους χρήστες να μοιράζονται και να ασχολούνται με όσο το δυνατόν περισσότερο περιεχόμενο, δείχνοντάς τους αναρτήσεις που είτε τους εξοργίζουν, είτε τους εξιτάρουν.

Η Χάο μιλησε με τον Κινιονέρο καθώς και με άλλα στελέχη του Facebook, νυν και πρώην υπαλλήλους και εξωτερικούς εμπειρογνώμονες. Πολλοί θέλησαν να διατηρήσουν την ανωνυμία τους επειδή είχαν υπογράψει συμφωνίες εμπιστευτικότητας ή φοβόντουσαν τα αντίποινα. Η δημοσιογράφος ήθελε να μάθει τι έκανε η ομάδα του Κινιονέρο για να περιορίσει το μίσος και τα ψέματα στην πλατφόρμα της.

Όμως, ο Έντιν και ο Κινιονέρο είχαν διαφορετική ατζέντα. Ήθελαν να συζητήσουν μόνο για το σχέδιο της ομάδας Responsible AI για την αντιμετώπιση ενός συγκεκριμένου είδους προβλήματος: την αλγοριθμική προκατάληψη, κατά την οποία οι αλγόριθμοι κάνουν διακρίσεις εις βάρος συγκεκριμένων ομάδων χρηστών.

«Μέχρι την εισβολή των υποστηρικτών του Τραμπ στο Καπιτώλιο των ΗΠΑ η οποία οργανώθηκε εν μέρει στο Facebook και τροφοδοτήθηκε από τα ψέματα περί κλεμμένων εκλογών που είχαν εξαπλωθεί σε όλη την πλατφόρμα, είχα καταλάβει ότι η ομάδα Responsible AI είχε αποτύχει να προχωρήσει στην καταπολέμηση της παραπληροφόρησης και της ρητορικής μίσους, επειδή δεν ήταν προτεραιότητά της. Το πιο σημαντικό όμως είναι ότι ακόμη αν προσπαθούσε να το κάνει, θα αποτύχαινε», γράφει η Χάο.

Ο λόγος είναι απλός. Όλα όσα κάνει και επιλέγει να μην κάνει η εταιρεία, απορρέουν από ένα και μόνο κίνητρο: την αμείλικτη επιθυμία του Ζούκερμπεργκ για ανάπτυξη. Η εμπειρογνωμοσύνη του Κινιονέρο στον τομέα της τεχνητής νοημοσύνης ενίσχυσε αυτή την ανάπτυξη. Η ομάδα του ανέλαβε να ερευνήσει το θέμα της μεροληψίας της τεχνητής νοημοσύνης, επειδή η αποτροπή αυτής της μεροληψίας βοηθά την εταιρεία να αποφύγει μια προτεινόμενη ρύθμιση, η οποία αν περάσει, θα μπορούσε να εμποδίσει αυτή την ανάπτυξη. Η ηγεσία του Facebook έχει επίσης επανειλημμένα αποδυναμώσει ή σταματήσει πολλές πρωτοβουλίες που αποσκοπούσαν στον έλεγχο και μείωση της παραπληροφόρησης στην πλατφόρμα, επειδή κάτι τέτοιο θα υπονόμευε αυτή την ανάπτυξη.

«Με άλλα λόγια, το έργο της ομάδας είναι ουσιαστικά άσχετο με τη διόρθωση των μεγαλύτερων προβλημάτων της παραπληροφόρησης, του εξτρεμισμού και της πολιτικής πόλωσης. Και το τίμημα το πληρώνουμε όλοι εμείς», σημειώνει η Χάο στο άρθρο της.

«Όταν έχεις ως στόχο τη μεγιστοποίηση της δέσμευσης, δεν σε ενδιαφέρει η αλήθεια. Δεν σε ενδιαφέρει η ζημιά, ο διχασμός, η συνωμοσία. Στην πραγματικότητα, αυτοί είναι οι φίλοι σου», είπε στην Χάο ο Χάνι Φαρίντ, καθηγητής στο Πανεπιστήμιο της Καλιφόρνιας στο Μπέρκλεϊ- ο οποίος σε συνεργασία με το Facebook- ερευνά το θέμα της παραπληροφόρησης μέσα από εικόνες και βίντεο που δημοσιεύονται στην πλατφόρμα.

«Πάντα κάνουν ακριβώς όσο χρειάζεται για να μπορέσουν να βγάλουν μια ανακοίνωση. Ποτέ δεν ασχολούνται πραγματικά με τα θεμελιώδη προβλήματα», πρόσθεσε.

MIT Technology Review – ertnews.gr